Robots.txt là một tệp tin văn bản nằm trong thư mục gốc của trang web và cung cấp hướng dẫn cho các công cụ tìm kiếm thu thập thông tin về các trang mà họ có thể thu thập thông tin để lập chỉ mục.

Một trong những điều tiên phong bạn cần phải kiểm tra và tối ưu hóa khi thao tác về SEO kỹ thuật của bạn là file robots.txt. Sự cố hoặc thông số kỹ thuật sai trong robots.txt của bạn hoàn toàn có thể gây ra những yếu tố SEO quan trọng hoàn toàn có thể tác động ảnh hưởng xấu đi đến thứ hạng và lượng truy vấn của bạn .Trong bài đăng này, bạn sẽ biết được file robots.txt là gì, tại sao bạn cần nó, làm thế nào để SEO tối ưu hóa nó và làm thế nào để kiểm tra rằng những công cụ tìm kiếm hoàn toàn có thể truy vấn nó mà không có bất kể yếu tố gì .

Nếu bạn đang sử dụng WordPress ở cuối bài viết này, bạn sẽ có thông tin cụ thể về tệp robots.txt mặc định của WordPress. Cũng có nhiều bạn mắc sai lầm trong những lần cài đặt website WordPress lần đầu, tôi sẽ phổ biến kèm nội dung dưới đây.

Robots.txt là gì?

Robots. txt là một tệp tin văn bản nằm trong thư mục gốc của website và phân phối hướng dẫn cho những công cụ tìm kiếm tích lũy thông tin về những trang mà họ hoàn toàn có thể tích lũy thông tin để lập chỉ mục .

Nếu bạn đã đọc bài trước của tôi về cách các công cụ tìm kiếm hoạt động, thì bạn sẽ biết rằng trong giai đoạn thu thập thông tin và lập chỉ mục, các công cụ tìm kiếm cố gắng tìm các trang có sẵn công khai trên web, mà chúng có thể đưa vào trong chỉ mục của chúng.

Khi truy vấn website, điều tiên phong công cụ tìm kiếm làm là tìm kiếm và kiểm tra nội dung của tệp robots.txt. Tùy thuộc vào những quy tắc được chỉ định trong tệp, chúng tạo ra một list những URLS hoàn toàn có thể thu thập dữ liệu và sau đó lập chỉ mục đơn cử cho website .

Nội dung của tệp robots.txt được công khai minh bạch trên Internet. Trừ khi được bảo vệ bằng cách khác ( tôi cũng chưa biết bảo vệ bằng cách nào ), bất kể ai cũng hoàn toàn có thể xem nội dung tệp robots.txt của bạn thế cho nên đây không phải là nơi để thêm nội dung mà bạn không muốn người khác xem .

Điều gì sẽ xảy ra nếu bạn không có tệp robots.txt? Nếu tệp robots.txt bị thiếu, trình thu thập thông tin của công cụ tìm kiếm giả sử rằng tất cả các trang có sẵn trên trang web của bạn đều ở chế độ công khai và nó có thể được thu thập dữ liệu -> thêm vào chỉ mục của nó.

Điều gì sẽ xảy ra nếu robots.txt không được định dạng tốt? Nó phụ thuộc vào vấn đề. Nếu các công cụ tìm kiếm không thể hiểu nội dung của tệp tin vì nó bị định cấu hình sai, họ vẫn truy cập vào trang web và bỏ qua bất cứ điều gì trong robots.txt.

Điều gì sẽ xảy ra nếu tôi vô tình chặn các công cụ tìm kiếm truy cập trang web của tôi? Đó là một vấn đề lớn. Đối với người mới bắt đầu, công cụ tìm kiếm sẽ không thu thập thông tin và lập chỉ mục trang từ trang web của bạn và dần dần họ sẽ xóa bất kỳ trang nào đã có trong chỉ mục của họ.

Bạn có cần tệp Robots.txt không?

Có, chắc như đinh bạn cần có robots.txt ngay cả khi bạn không muốn loại trừ bất kể trang hoặc thư mục nào của website khỏi Open trong hiệu quả của công cụ tìm kiếm .

Tại sao lại sử dụng robots.txt?

Các trường hợp sử dụng robots.txt phổ cập nhất là như sau :

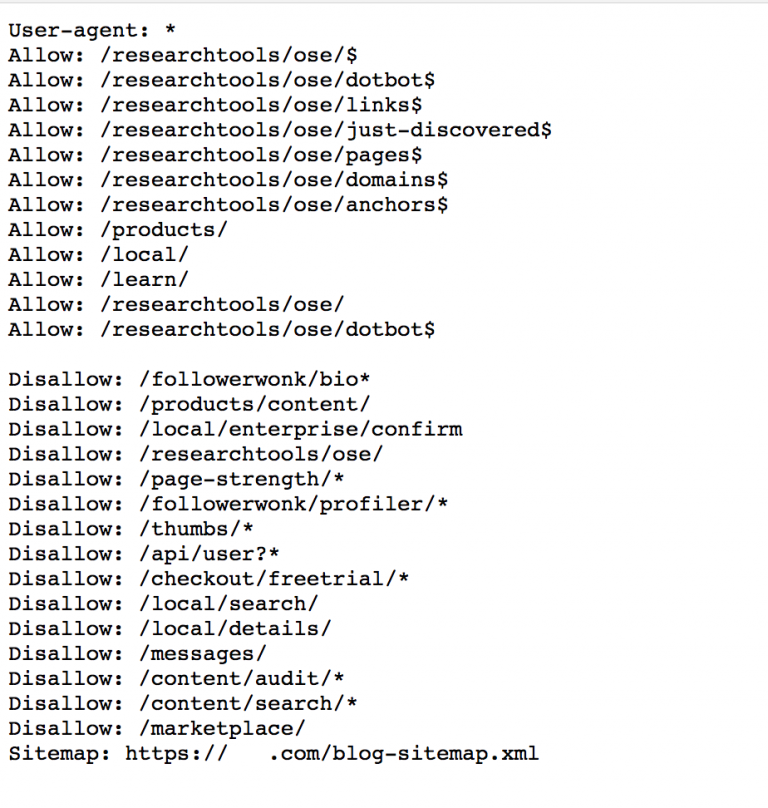

# 1 – Để chặn các công cụ tìm kiếm truy cập các trang hoặc thư mục cụ thể của trang web của bạn. Ví dụ: xem robots.txt bên dưới và chú ý đến các quy tắc không cho phép.

Ví dụ về Robots. txtCác câu lệnh này hướng dẫn trình tích lũy thông tin của công cụ tìm kiếm không lập chỉ mục những thư mục đơn cử. Lưu ý rằng bạn hoàn toàn có thể sử dụng ký tự * làm ký tự thẻ tự do. Ví dụ trên bạn nhìn dòng Disallow : / followerwonk / bio * thì toàn bộ những tệp, trang tại thư mục / followerwonk / bio đều bị chặn, ví dụ : Disallow : / followerwonk / biovietnet.html hoặc Disallow : / followerwonk / biovietnet .

# 2 – Khi bạn có một trang web lớn, thu thập thông tin và lập chỉ mục có thể là một quy trình rất tốn tài nguyên. Trình thu thập thông tin từ các công cụ tìm kiếm khác nhau sẽ cố gắng thu thập dữ liệu và lập chỉ mục toàn bộ trang web của bạn và điều này có thể gây ra các vấn đề về hiệu năng nghiêm trọng.

Trong trường hợp này, bạn hoàn toàn có thể sử dụng robots.txt để hạn chế quyền truy vấn vào một số ít phần nhất định của website mà không quan trọng so với SEO hoặc thứ hạng. Bằng cách này, bạn không chỉ làm giảm tải trên sever của bạn mà nó làm cho hàng loạt quy trình lập chỉ mục nhanh hơn .

# 3 – Khi bạn quyết định sử dụng URL rút gọn cho liên kết liên kết của mình. Không giống như che giấu nội dung hoặc che giấu URLS để lừa người dùng hoặc công cụ tìm kiếm thì đó là quy trình hợp lệ để làm cho các liên kết liên kết của bạn dễ quản lý hơn.

Hai điều quan trọng cần biết về robots.txt

Điều tiên phong là bất kể quy tắc nào bạn thêm vào robots.txt thì đó là thông tư. Điều này có nghĩa là công cụ tìm kiếm phải tuân theo và tuân theo những quy tắc bạn đã đưa vào .Trong hầu hết những trường hợp công cụ tìm kiếm đều mò vào việc làm thu thâp -> lập chỉ mục, nhưng nếu bạn có nội dung mà bạn không muốn nằm trong chỉ mục của họ thì cách tốt nhất là để mật khẩu bảo vệ thư mục hoặc trang cụ thể .Điều thứ hai là ngay cả khi bạn chặn trang hoặc thư mục trong robots.txt, nó vẫn hoàn toàn có thể Open trong hiệu quả tìm kiếm nếu nó có link từ những trang khác đã được lập chỉ mục. Nói cách khác, thêm trang bạn muốn chặn vào robots.txt không bảo vệ rằng nó sẽ bị xóa hoặc không Open trên web. Trước đây tôi có liên tục nhìn thấy những tác dụng với diễn đạt “ Không có miêu tả cho hiệu quả tìm kiếm hoặc bị chặn ” .

Ngoài mật khẩu bảo vệ trang hoặc thư mục, một cách khác là sử dụng chỉ thị của trang bằng cách thêm vào trong

của mỗi trang một thẻ meta như dưới đây thì sẽ chặn được việc lập chỉ mục:

Robots.txt hoạt động như thế nào?

Tệp robot có một cấu trúc rất đơn thuần. Có một số ít phối hợp từ khóa / giá trị được xác lập trước mà bạn hoàn toàn có thể sử dụng .Phổ biến nhất là : User-agent, Disallow, Allow, Crawl-delay, Sitemap .

User-agent: Chỉ định trình thu thập dữ liệu nào được đưa vào các chỉ thị. Bạn có thể sử dụng một * để cho tất cả các trình thu thập thông tin hoặc nếu không thích thì bạn có thể chỉ định tên của trình thu thập thông tin, xem ví dụ dưới đây.

Bạn hoàn toàn có thể xem toàn bộ những tên và giá trị có sẵn cho thông tư user-agent, tại đây .

User-agent: * – bao gồm tất cả trình thu thập thông tin.

User-agent: Googlebot – chỉ dành cho Google bot.

Disallow: Chỉ thị hướng dẫn các bot (được chỉ định ở trên) không thu thập dữ liệu URL hoặc một phần của trang web.

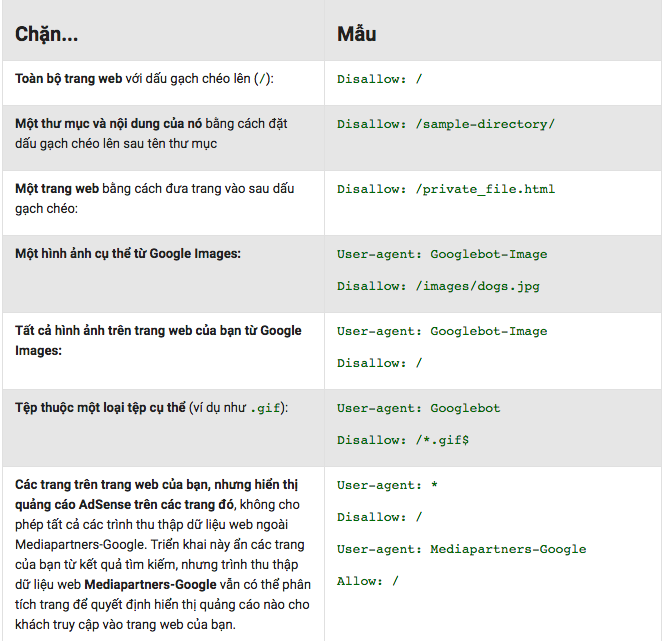

Giá trị của disallow hoàn toàn có thể là một tệp, URL hoặc thư mục đơn cử. Xem ví dụ dưới đây được thực thi từ bộ phận tương hỗ kỹ thuật của Google .

Allow: Chỉ thị cho biết rõ các trang hoặc thư mục con nào có thể được truy cập. Điều này chỉ áp dụng cho Googlebot.

Bạn hoàn toàn có thể sử dụng Allow để cho phép truy vấn vào một thư mục con đơn cử trên website của bạn, mặc dầu thư mục gốc là không được phép .Ở ví dụ dưới đây tôi chặn thư mục photo nhưng tôi tại được cho phép lập chỉ mục trong photos / vietnetgroup

User-agent: *

Disallow: /photos

Allow: /photos/vietnetgroup/

Crawl-delay: Bạn có thể để cụ thể một giá trị để buộc trình thu thập dữ liệu thu thập thông tin của công cụ tìm kiếm đợi một khoảng thời gian cụ thể trước khi thu thập thông tin trang tiếp theo từ trang web của bạn. Giá trị bạn nhập đơn vị là mili giây.

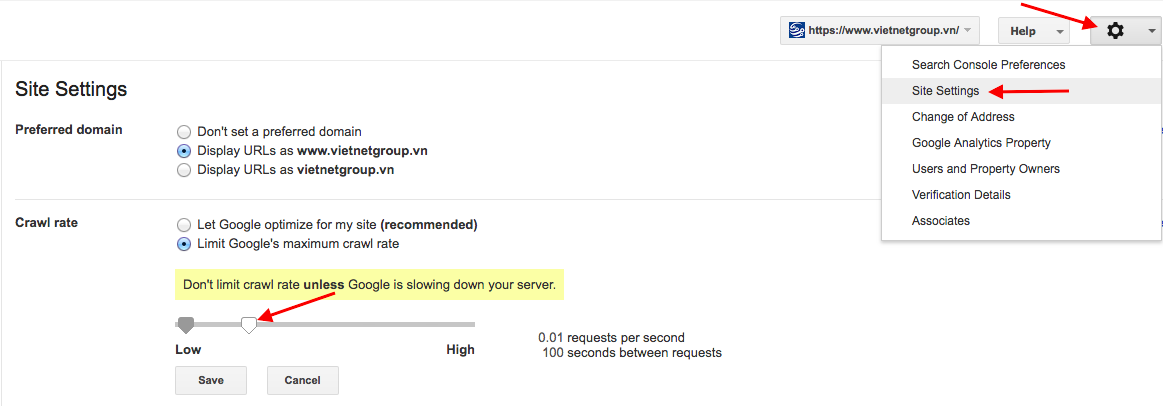

Cần chú ý quan tâm rằng Googlebot không tính đến độ Crawl-delay này .Bạn hoàn toàn có thể sử dụng Google Search Console để trấn áp vận tốc tích lũy thông tin cho Google ( tùy chọn này ở trong Cài đặt website ) tôi chụp ảnh màn hình hiển thị dưới đây .

Bạn có thể sử dụng Crawl-delay trong trường hợp bạn có trang web với hàng ngàn trang và bạn không muốn quá tải máy chủ của mình với các yêu cầu liên tục.

Trong phần đông những trường hợp, bạn không nên sử dụng thông tư thu thập dữ liệu trễ này làm gì .

Sitemap: Chỉ thị sitemap được hỗ trợ bởi các công cụ tìm kiếm chính bao gồm Google và nó được sử dụng để chỉ định vị trí của Sơ đồ trang web XML của bạn. (Nếu muốn xem bài sơ đồ trang XML thì nhấp vào link bên cạnh đó nhé)

Ngay cả khi bạn không chỉ định vị trí của sơ đồ trang XML trong robot.txt, những công cụ tìm kiếm vẫn hoàn toàn có thể tìm thấy nó .

Một điều chú ý quan tâm quan trọng cho bạn đó là robots có phân biệt chữ hoa và chữ thường. Ví dụ : Disallow : / File. html thì sẽ không khóa được file.html

Cách tạo file robots.txt

Tạo tệp robots.txt rất thuận tiện. Tất cả bạn cần là một trình soạn thảo văn bản ( tôi thường xùng notepad ) và truy vấn những tệp của website của bạn ( qua FTP hoặc bảng điều khiển và tinh chỉnh quản trị hosting ) .Trước khi tham gia quy trình tạo tệp tin robot, điều tiên phong cần làm là kiểm tra xem nó đã có chưa .Cách dễ nhất để thao tác này là mở một hành lang cửa số trình duyệt mới và truy vấn đến https://www.tênmiền.com/robots.txtNếu bạn thấy một thứ tương tự như như dưới đây, có nghĩa là bạn đã có tệp robots.txt và bạn hoàn toàn có thể chỉnh sửa tệp hiện tại thay vì tạo tệp mới .

User-agent : *Allow : /

Cách chỉnh sửa robots.txt

Sử dụng ứng dụng khách FTP và liên kết với thư mục gốc của website của bạn .Robots. txt luôn nằm trong thư mục gốc ( www hoặc public_html, tùy thuộc vào sever của bạn ) .Tải tập tin về máy tính của bạn và mở nó bằng một trình soạn thảo văn bản .Thực hiện những đổi khác thiết yếu và tải tệp lên sever của bạn .Ví dụ về tệp tin robots.txt

User-agent: *

Allow: /

Sitemap: https://example.com/sitemap.xml

Điều này được cho phép toàn bộ những chương trình truy vấn website của bạn mà không chặn bất kể thư mục, url nào. Nó cũng xác lập vị trí sơ đồ website để làm cho những công cụ tìm kiếm dễ tìm nó hơn .

Cách kiểm tra và xác nhận hợp lệ cho robots.txt?

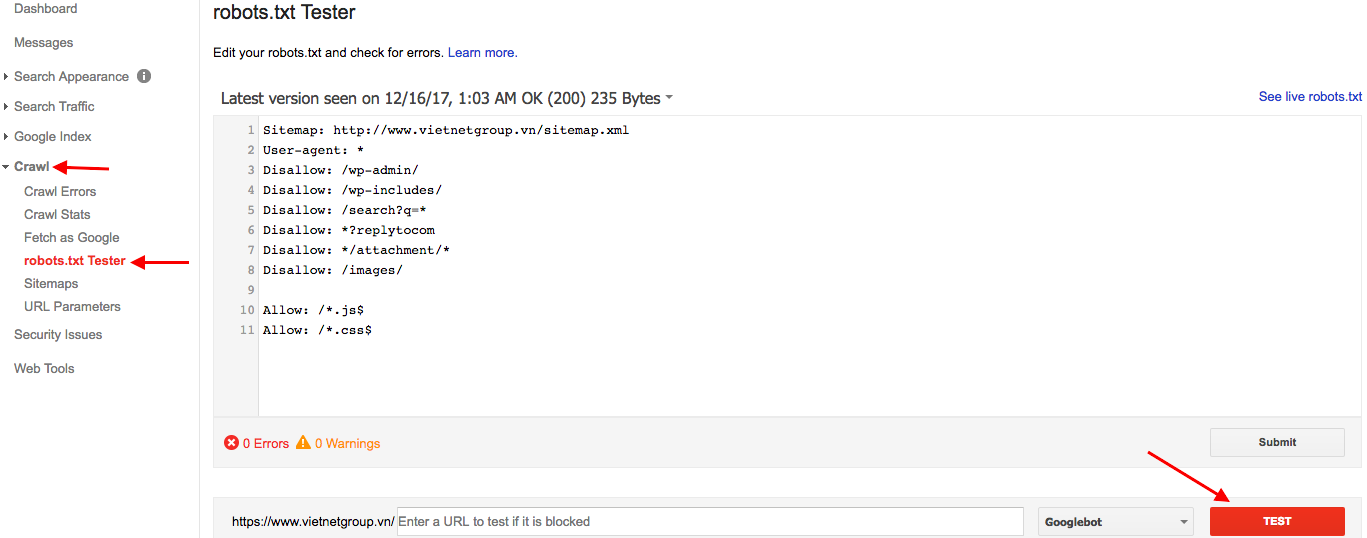

Mặc dù bạn hoàn toàn có thể xem nội dung robots.txt của mình bằng cách điều hướng tới robots.txt URL nhưng cách tốt nhất để kiểm tra và xác nhận nó là trải qua tùy chọn robots.txt Tester của Google Search Console .Đăng nhập vào Tài khoản Google Search Console của bạn .

Nhấp vào robots.txt Tester, được tìm thấy trong Tùy chọn Crawl.

Nhấp vào nút TEST .Nếu mọi thứ đều ổn, nút Test sẽ chuyển sang màu xanh và nhãn sẽ biến hóa ALLOWED. Nếu xảy ra sự cố, đường kẻ gây ra lỗi sẽ được lưu lại .

Một vài điều nữa cần biết về robots.txt Tester:

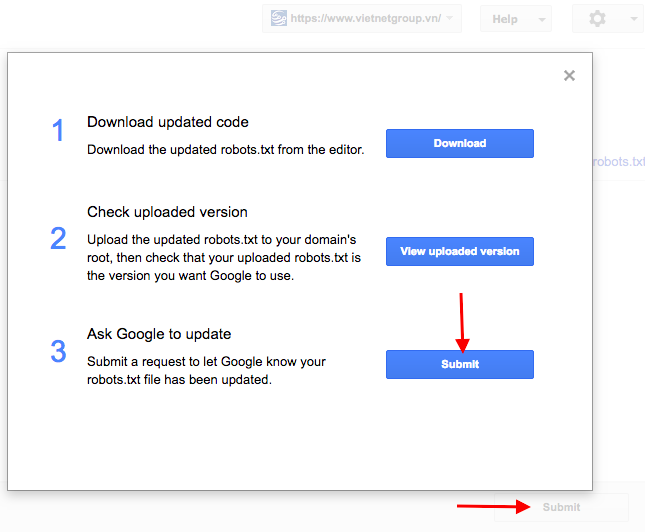

Bạn hoàn toàn có thể sử dụng URL Tester ( dưới cùng của công cụ ) để nhập URL từ website của bạn và kiểm tra xem nó có bị chặn hay không .Bạn hoàn toàn có thể triển khai bất kể biến hóa nào so với trình soạn thảo và kiểm tra những quy tắc mới nhưng để những ứng dụng này được vận dụng cho robots.txt trực tiếp của bạn, bạn cần EDIT tệp của mình bằng trình chỉnh sửa văn bản và tải tệp lên thư mục gốc của website của bạn ( như đã lý giải ở trên ) .Để thông tin cho Google rằng bạn đã triển khai đổi khác robots.txt, hãy nhấp vào nút SUBMIT ( từ ảnh màn hình hiển thị ở trên ) và nhấp vào nút SUBMIT một lần nữa từ hành lang cửa số bật lên ( tùy chọn 3 như được hiển thị bên dưới ) .

Robots.txt với WordPress?

Tất cả những gì bạn đọc cho đến nay về robots.txt cũng vận dụng cho những website WordPress .Những điều bạn cần biết về robots.txt và WordPress là như sau :WordPress mặc định sử dụng tệp robots.txt ảo. Điều này có nghĩa là bạn không hề trực tiếp chỉnh sửa tập tin hoặc tìm nó trong thư mục gốc của thư mục của bạn .Cách duy nhất để xem nội dung của tệp là gõ https://www.tênmiền.com/robots.txt trong trình duyệt của bạn .Các giá trị mặc định của WordPress robots.txt là :

User-agent: *

Disallow: / wp-admin /

Allow: /wp-admin/admin-ajax.php

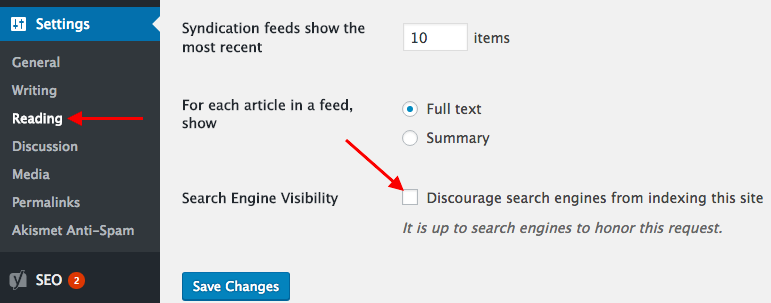

Sử dụng Plugins Yoast SEO thì mọi thứ thuận tiện hơi với việc chỉnh sửa file robots.txt bằng thao tác bạn vào SEO -> Tools -> File editor và chỉnh nội dung robots.txt sau đó lưu lại .Thêm một điều nữa chú ý quan tâm mà khi những bạn thiết lập WordPress thường gặp đó là việc những bạn lựa chọn chặn toàn bộ những công cụ tìm kiếm đến website. Điều này tôi cũng thường làm khi mới khởi đầu kiến thiết xây dựng 1 Website WordPress, nhưng sau khi hoàn thành xong thì tôi sẽ mở ra cho những công cụ tìm kiếm vào .

Nếu bạn tích vào ô đó thì mọi công cụ tìm kiếm sẽ không vào Website của bạn

Robots.txt thực tế tốt nhất cho SEO

Kiểm tra robots.txt của bạn và bảo vệ rằng bạn không chặn bất kể phần nào của website mà bạn muốn Open trong những công cụ tìm kiếm .Không chặn thư mục CSS hoặc JS. Google trong quy trình tích lũy thông tin và lập chỉ mục hoàn toàn có thể xem một website như một người dùng thực và nếu những trang của bạn cần JS và CSS hoạt động giải trí đúng cách, chúng sẽ không bị chặn .Nếu bạn đang sử dụng WordPress, bạn không cần phải chặn truy vấn vào những thư mục wp-admin và wp-include. WordPress triển khai việc làm tuyệt vời bằng thẻ meta robots. Tuy nhiên, làm thì cũng không sao .

Không nên cố gắng chỉ định các quy tắc khác nhau cho mỗi bot của công cụ tìm kiếm, nó có thể gây nhầm lẫn và khó để cập nhật. Sử dụng user-agent tốt nhất là: * và cung cấp một bộ quy tắc cho tất cả các chương trình.

KẾT LUẬN

Bạn không phải mất quá nhiều thời hạn để thông số kỹ thuật hoặc thử nghiệm robots.txt của mình. Điều quan trọng là phải có và thử nghiệm trải qua Công cụ Quản trị Trang web của Google để chắc như đinh rằng bạn không chặn trình tích lũy thông tin của công cụ tìm kiếm truy vấn vào website của bạn .Đó là một việc làm bạn cần làm một lần khi bạn lần tiên phong tạo website của bạn hoặc như một phần kỹ thuật tiên phong khi bạn kiểm tra SEO một website .

Biên soạn: Phong Vũ